【新智能导读】xLAM-1B 仅拥有 10 亿个参数,在特定任务上击败了 LLM 霸主:OpenAI 的 GPT-3.5 Turbo 和 Anthropic 的 Claude-3 Haiku。上个月刚发布的苹果智能模型只有 30 亿个参数。连 Altman 都说我们正处于大模型时代的末期。那么,小型语言模型 (SLM) 会是 AI 的未来吗?

大型语言模型的缩放定律被一些人视为“黄金法则”,但也有人不以为然。前段时间,香港大学马毅教授公开宣称,“如果你认为仅靠缩放定律就能实现 AGI,那你就应该转行了。”

确实,很多模式脱颖而出,并不是靠简单地堆砌资源,而是依靠创新,这也印证了一条与规模法则不同的道路:少即是多。

xLAM-1B 就是这种情况,它只有 10 亿个参数,但在函数调用任务上的表现优于更大的模型,包括 OpenAI 的 GPT-3.5 Turbo 和 Anthropic 的 Claude-3 Haiku。

因此它也被称为“Tiny Giant”——小巨人!

凭借远超预期的出色表现,这款小型模型或将改变边缘AI的格局。

西方人把这种弱肉强食的故事称为“大卫与歌利亚”,这出自圣经故事——大卫与巨人歌利亚战斗时还是个孩子,他没有像歌利亚那样穿着铠甲,于是他捡起一块石头,放在投石器里,将石头扔出去,击中歌利亚的额头,将巨人击倒在地。

科技媒体 Venturebeat 在报道这个小模型时,将其比喻为人工智能领域的“大卫与歌利亚”的时刻。

我们最关心的一点是,xLAM-1B是如何做到的?

简而言之,这归功于数据处理方面的创新方法。其背后的团队开发了 APIGen,这是一种自动化流程,可以生成高质量、多样化且可验证的数据集,用于在函数调用任务中训练 AI 模型。

论文地址:

小而强大:高效人工智能的力量

xLAM-1B 最令人兴奋的地方在于它不占用太多空间。由于模型很小,因此适合设备端应用。这对企业 AI 的影响是巨大的,有可能使 AI 助手更加强大、响应更快,并在智能手机或其他计算资源有限的设备上本地运行。

训练数据的质量和多样性是支撑 xLAM-1B 强大性能的关键。APIGen 自动数据生成管道使用来自 21 个不同类别的 3,673 个可执行 API,并对每个数据点进行严格的三阶段验证:格式检查、实际函数执行和语义验证。

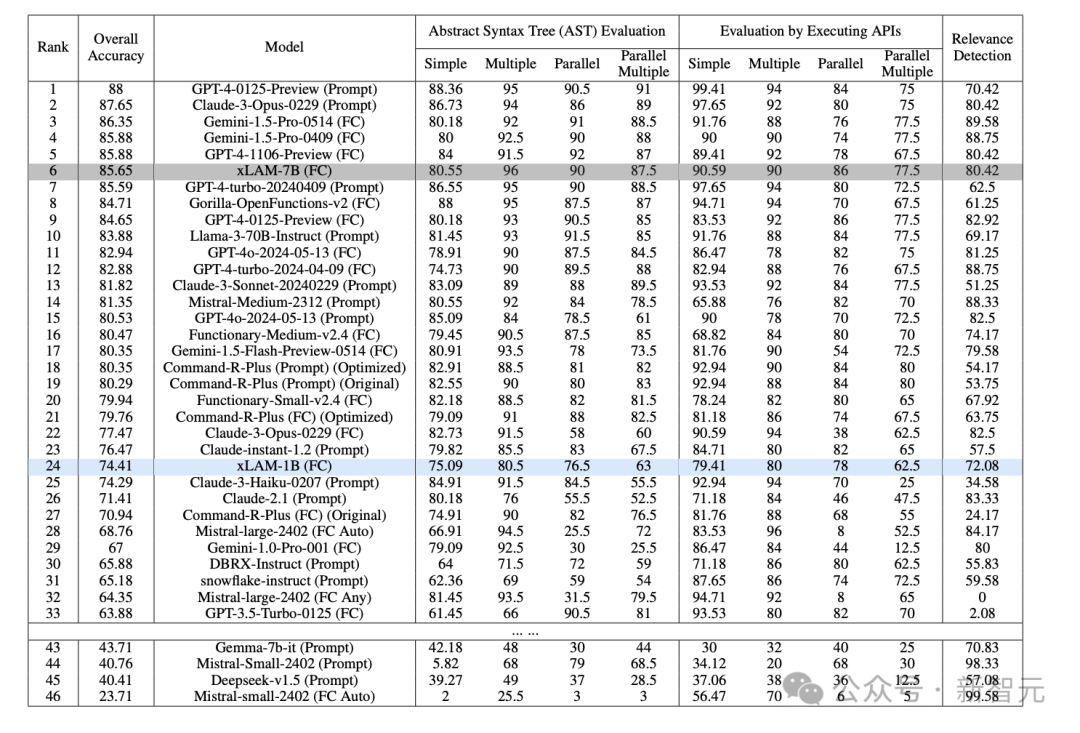

不同评估指标下各种 AI 模型的性能比较。GPT-4-0125-Preview 在整体准确率上遥遥领先,而 xLAM-7B 等小型模型在特定任务中表现出色,挑战了大型模型总是表现更好的说法。

这种方法代表了人工智能发展战略的重大转变。

尽管许多公司都在竞相构建越来越大的模型,但 xLAM-1B 所采用的方法表明,更智能的数据处理可以带来更高效的人工智能系统。

通过关注数据质量而不是模型大小,xLAM-1B 提供了一个很好的示例,说明如何以比竞争对手少得多的参数执行复杂任务。

颠覆人工智能现状:从法学硕士 (LLM) 到学术硕士 (SLM)

此次突破的潜在影响远不止xLAM-1B模型的发射。

通过证明更小、更高效的模型可以与更大的模型相竞争,xLAM-1B 正在挑战 AI 业界的主流观点,成为小型语言模型(SLM)战争中一支新力量,对抗主导业界的大型语言模型(LLM)。

科技公司一直在竞相打造最大的语言模型。例如,今年 4 月,Meta 发布了 Llama 3,它拥有 4000 亿个参数,是 OpenAI 于 2022 年推出的原始 ChatGPT 模型参数数量的两倍。

虽然尚未得到证实,但 GPT-4 估计有大约 1.8 万亿个参数。

不过,在过去的几个月里,包括苹果和微软在内的一些最大的科技公司已经推出了小型语言模型。

这些模型的大小只是 LLM 模型的一小部分,但在许多基准测试中,它们在文本生成方面的表现与 LLM 相当或更好。

6月10日,苹果全球开发者大会上,发布了拥有约30亿个参数的苹果智能模型。

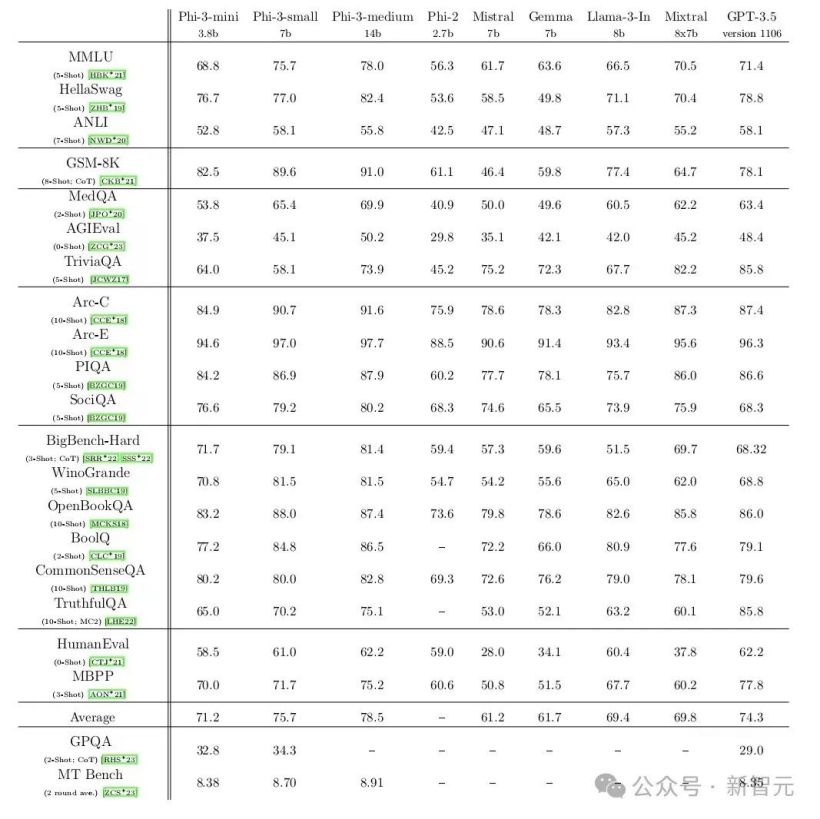

4 月下旬,微软发布了 Phi-3 SLM 系列,该系列拥有 38 亿至 140 亿个参数。

在一系列测试中,微软最小的模型 Phi-3-mini 与 OpenAI 的 GPT-3.5(1750 亿个参数)相当,并优于谷歌的 Gemma(70 亿个参数)。

该测试通过询问数学、哲学、法律等问题来评估模型理解语言的能力。

更有趣的是,拥有 70 亿个参数的 Microsoft Phi-3-small 在许多基准测试中的表现明显优于 GPT-3.5。

波士顿东北大学研究语言模型的 Aaron Müller 对于 SLM 在某些方面可与 LLM 相提并论并不感到惊讶。

“这是因为简单地增加参数数量并不是提高模型性能的唯一方法;对更高质量的数据进行训练也可以产生类似的结果,”Müller 说。

例如,微软的 Phi 模型是在经过微调的“教科书质量”数据上进行训练的,与 LLM 通常依赖的来自互联网的高度多样化的文本相比,该数据在风格上更加一致,也更容易学习。

同样,苹果正在使用高质量、更复杂的数据集训练 SLM。

更重要的是,SLM 可以使语言模型的使用民主化,Müller 说。

迄今为止,人工智能开发集中在少数有能力部署高端基础设施的大公司手中,而其他较小的公司和实验室则必须支付高额费用才能获得许可证。

由于 SLM 可以在更便宜的硬件上轻松进行训练,因此资源有限的人更容易使用它。

SLM的兴起恰逢LLM之间性能差距的快速缩小,科技公司希望探索除了Scaling Law之外的其他性能升级路径。

在四月份的一次活动中,OpenAI 首席执行官 Altman 表示,他认为我们正处于大模型时代的终结。“我们将通过其他方式让模型变得更好。”

也就是说,精心规划的 SLM 距离构建可解释的 AI 更近了一步。

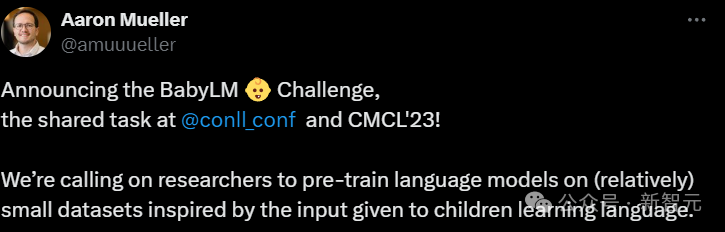

对于像苏黎世联邦理工学院计算机科学研究员 Alex Warstadt 这样的研究人员来说,SLM 还可以为一个长期存在的科学问题提供新的见解:儿童如何利用很少的文本数据学习语言和思考。

Warstadt 和包括东北大学的 Müller 在内的一组研究人员组织了 BabyLM 挑战赛,参赛者试图在小数据上优化语言模型训练。

SLM 不仅有可能解开人类认知的新秘密,而且还有助于改善生成人工智能。

到孩子们 13 岁时,他们已经接触了大约 1 亿个单词,这使得他们的语言能力比聊天机器人更先进,但他们只能接触到 0.01% 的数据。

虽然没有人知道是什么让人类如此高效,但“小规模的高效类人类学习在扩大到法学硕士规模时可能会带来巨大的进步,”沃施塔特说。

重塑人工智能的未来:从云端到设备

xLAM-1B所展现出的边缘AI发展潜力,很可能标志着人工智能领域的一次重大转变——挑战“模型越大越好”的观念,让人工智能在消耗有限资源的情况下继续成长。

目前,许多先进的人工智能功能由于所涉及模型的规模和复杂性而依赖于云计算。

如果像 xLAM-1B 这样的小型模型可以提供类似的功能,它可以让更强大的人工智能助手直接在用户的设备上运行,使它们的响应速度更快,并解决与基于云的人工智能相关的隐私问题。

随着边缘计算和物联网设备的激增,对更强大的设备人工智能功能的需求也将激增。

xLAM-1B 的成功可能会激发新一轮的人工智能开发浪潮,专注于创建针对特定任务的超高效模型,而不是“万事通”的庞然大物。

这可能带来一个更加分布式的人工智能生态系统,其中专门的模型可以通过设备网络协同工作,从而有可能提供更强大、响应更快、更能保护隐私的人工智能服务。

这一发展还可以使人工智能功能民主化,允许小公司和开发人员创建复杂的人工智能应用程序,而无需大量的计算资源。

此外,它还可以减少人工智能的碳足迹,因为较小的模型需要更少的能量来训练和运行。

xLAM-1B 为行业带来了很多东西,但有一点是明确的:在人工智能的世界里,大卫刚刚证明他不仅可以与巨人竞争,还可以消灭它。人工智能的未来可能不再由云端的巨头控制,而是掌握在你自己手中。

参考:

评论(0)